Entre as figuras de linguagem, eu tenho uma grande predileção por metáforas. Elas são mais que transformações quase poéticas de descrições secas e diretas. São também representações de sofisticados processos cognitivos. Metáforas requerem uma capacidade sofisticada de abstração, ou seja, da separação da forma do conteúdo, bem como da transferência dessa forma para outro conteúdo. Ao fazermos isso, somos capazes de transferir em poucas palavras uma estrutura conceitual inteira.

Por exemplo, quando dizemos que “Alan Turing foi o Pelé da computação” ou que “Pelé foi o rei do futebol”, estamos realizando as seguintes operações: primeiro, extraímos uma estrutura conceitual na qual reconhecemos certas capacidades humanas, bem como um coletivo unificado em torno dessas capacidades, e no qual um indivíduo é soberano; depois, transferimos essa estrutura de uma situação para outra.

Nesses exemplos: primeiro a transferimos do rei como agente soberano em sua capacidade de deliberação entre os seus súditos para Pelé (absoluto em suas capacidades de jogador entre jogadores), e depois para Turing em sua capacidade de influência intelectual dentro da comunidade de cientistas da computação. Quando alguém entende a frase “Elvis foi o rei do Rock”, entende sem qualquer explicação adicional essa estrutura de conhecimento inteira.

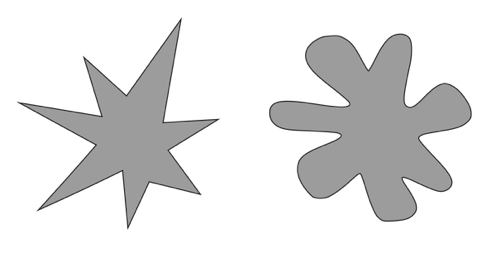

Existe um fenômeno mental chamado sinestesia que confere a algumas pessoas a capacidade de percepção cruzada e é associado à abstração e a transferência de formas, ou seja, um tipo de capacidade metafórica basilar. Para descobrir se você é um sinesteta, olhe para figura abaixo. Uma dessas criaturas é chamada Kiki e a outra é chamada Buba. Qual é qual?

Se você atribuiu Kiki a figura da esquerda, então você passou no teste – você está transferindo a inflexão da onda sonora da palavra falada “Kiki” para a mudança afiada e repentina de ângulo das formas da figura à esquerda.

Somos quase todos sinestetas, pelo menos em um nível básico, o que demonstra o quanto essas capacidades metafóricas estão presentes em nossa cognição. No entanto, existem sinestetas em alto grau. Para alguns deles (ou melhor, para alguns de nós), por exemplo, números diferentes são visualizados em cores diferentes, notas musicais diferentes geram gostos diferentes na boca, estruturas abstratas como fórmulas matemáticas são visualizadas de maneiras extremamente concretas. Esses sinestetas são muitíssimos mais comuns em dois grupos se comparados com o restante da população: artistas e cientistas.

O primeiro não deve ser uma surpresa, a capacidade metafórica é a base da criatividade. Acharemos exemplos aqui em quase toda grande obra de arte: “Samba de uma nota só” (de Tom Jobim) transfere para letra o que está acontecendo com a harmonia; em vários de seus quadros, Picasso usa o Minotauro como uma metáfora de si mesmo (o monstro viril, mas frágil e cego percorrendo labirintos), e na literatura exemplos podem ser encontrados de Mario Quintana (“Da vez primeira em que me assassinaram, perdi um jeito de sorrir que eu tinha. Depois, de cada vez que me mataram, foram levando qualquer coisa minha”) a Rita Lee (“Amor é pensamento, teorema. Amor é novela. Sexo é cinema”).

O que talvez possa causar surpresa é a importância da metáfora na ciência. Pois grande parte da criatividade e inovação na ciência também se dá através de operações mentais metafóricas que dependem da capacidade de cientistas visualizarem estruturas ainda não compreendidas ou que simplesmente ainda não existem.

O historiador da tecnologia Eugene Fergusson uma vez escreveu em seu excelente livro “A Engenharia e o Olho da Mente” (Engineering and the Mind’s Eye): “Pirâmides, catedrais e foguetes não existem por causa da geometria, das teorias das estruturas ou da termodinâmica, mas porque foram primeiro imagens – literalmente visões – nas mentes daqueles que os conceberam”.

Metáforas são extremamente comuns em ciência: dos buracos negros aos de minhoca (worm holes) até as teorias das supercordas. A área de inteligência artificial é também recheada de metáforas: “alucinação”, “rede neuronal (ou rede neural)”, “aprendizagem de máquina”, “memoria de máquina”, “raciocínio”, “cadeia de pensamento”, “consciência de máquina”, “explicabilidade”, “agentes em IA”, e a mãe de todas elas: “inteligência” artificial.

Como discutido neste excelente artigo da historiadora Joannie Penn da Universidade de Cambridge, no Reino Unido, nos primeiros anos da IA, os pioneiros da área usavam esses termos sempre entre aspas, sinalizando claramente seu uso metafórico. Com o tempo, as aspas desapareceram e a própria comunidade científica começou a se comportar como se esses termos designassem seus referentes de forma literal, sinalizando que máquinas fossem realmente capazes de alucinar, raciocinar, aprender. Por falta de espaço, focalizamos alguns deles:

Modelos de linguagem não são capazes de alucinar. A alucinação pressupõe uma experiência consciente e que o sujeito da alucinação entenda o conteúdo semântico dessa. Modelos de linguagem não entendem nada, somente correlacionam termos estatisticamente.

Além disso, modelos de linguagem não são conscientes e existem argumentos técnicos que demonstram que, com a tecnologia atual, nunca poderiam sê-lo. O processo mental que mais se aproximaria aqui (ainda que metaforicamente) é confabulação, ou seja, a invenção de fatos para cobrir "buracos" da memória.

O termo “agentes de IA” é infeliz para designar sistemas que simplesmente executam seus processos de forma independente, mas desprovidos de verdadeira agência, intencionalidade e autonomia, ou seja, da capacidade de formar suas crenças, desejos, e intenções e de operar sob suas próprias regras e decisões (como discuto em detalhes aqui). Aliás, nesse mesmo texto, argumento porque “explicação” é também um termo inadequado para o que esses sistemas fazem.

Ainda neste texto, volto ao tema da autonomia e sua relação com controle, mas, por ora, vale agradecer que esses não a tenham, dado que não podemos garantir a sua confiabilidade. Por exemplo, se não podemos garantir que um único deles estará livre de “confabulações”, imagine um conjunto deles alimentando os erros uns aos outros.

“Aprendizagem de Máquina” também é uma metáfora ruim: essas “redes neurais artificiais” populares não aprendem depois de sua fase de “treinamento” (o que também é uma metáfora para ajuste dos valores numéricos em uma estrutura matemática). Uma vez treinadas, elas têm que ser retreinadas para um novo comportamento.

Portanto, não, GPT não aprende nada de novo diretamente pela sua interação com ele, o que você percebe como aprendizado é uma ilusão. Para usar uma metáfora biológica, o nosso aprendizado acontece de forma lamarckiana (no nível de indivíduo), e GPT e afins “aprendem” de forma darwinista, ou seja, em versões sucessivas de membros da mesma espécie (cada processo de “treinamento” produz um novo sistema).

Inteligência real pode ser interpretada como a capacidade de resolver problemas complexos e de forma flexível, inclusive em situações inéditas, ou em outras palavras, como dizia o psicólogo Jean Piaget, “a capacidade de saber o que fazer quando não sabemos o que fazer”.

Nós conseguimos fazer isso de forma tão natural pela nossa capacidade metafórica e, como ela, porque somos capazes de transferir o nosso conhecimento a situações completamente novas. Por exemplo, imagine-se dirigindo à noite e encontrando o seguinte objeto no meio da pista.

Nessa situação inédita, você saberia exatamente o que fazer porque é capaz de abstrair que aquilo é um objeto físico e, portanto, sólido e com massa muito superior ao seu carro, que a colisão com ele traria a destruição do seu carro, pensaria sobre possíveis intenções dos tripulantes etc. Através de operações metafóricas, você usa tudo que você sabe sobre objetos físicos, eventos, causalidade e agência vivenciadas em outras situações para deliberar sobre aquela.

Por fim, redes neurais artificiais também têm pouquíssima relação com redes neurais naturais. O “cérebro” por trás de ChatGPT (ou Claude, ou Mistral) é uma metáfora longínqua do cérebro humano. Na verdade, até um único “neurônio artificial” (uma função matemática, ou um comando do tipo “se...então...senão”) é uma pálida metáfora de um neurônio natural. Redes neuronais naturais e até neurônios naturais são estruturas extremamente complexas, as quais ainda estamos longe de compreender.

Eles são “computadores analógicos” que computam com sua própria estrutura físico-química-biológica. Em um neurônio real, os processos informacionais são inseparáveis dos processos de manutenção contínua da existência do neurônio e as conexões neuronais são tridimensionais, carregam mais do que sinais informacionais e são sujeitas a sinais químicos gasosos que atravessam membranas celulares e modulam o comportamento de circuitos neuronais inteiros.

O uso desses termos sem aspas gera confusão e apreensão entre as pessoas e frequentemente alimenta a nossa propensão à apofenia, e nos faz atribuir indevidamente agência, intencionalidade, autonomia e inteligência a esses sistemas. Eles também influenciam alguns cientistas que, no limite, passam a acreditar nas suas próprias metáforas.

A indissociabilidade entre o que o neurônio (e, portanto, o cérebro) faz e o que ele é trata-se de um exemplo importante, pois a sua negação é a base de vários mitos construídos pela comunidade de IA e nos quais ela acaba acreditando. A construção teórica aqui é o que é chamado de “funcionalismo computacional”, filosoficamente um tipo de neo-cartesianismo, mas que podemos resumir como a metáfora do cérebro como um hardware e da mente como um tipo software. Como em um computador, a mente funcionaria independentemente do cérebro, ou seja, independentemente do hardware, e a inteligência só requereria regras que, por sua vez, poderiam ser extraídas de dados sobre a realidade (ao invés de interações reais com ela).

Isso dá vazão a apostas que tem sido repetidamente falsificadas (como a “hipótese da escala”) e sonhos delirantes de um dia sermos capazes de transferir a nossa mente para uma máquina e assim alcançar a vida eterna. Um sonho comum a vários magnatas do Vale do Silício, mas incrivelmente não original - o texto mais antigo conhecido pela humanidade (“A Epopeia de Gilgamesh”) já ilustrava, e de forma mais interessante, esse desejo.

O artigo de Joannie Penn que menciono acima vai além ao analisar as consequências dessa metáfora de cérebro-como-mente e de “redes neurais artificiais”: se o computador é um cérebro, ao construirmos um “cérebro artificial” poderíamos desvendar o funcionamento das redes neurais/cérebros biológicos. Isso transforma a IA em mais do que ciência e engenharia da computação, mas em um tipo de ciência natural, como a física ou a biologia.

Nessa metáfora, dados são vistos como “recursos naturais” e, portanto, desprovidos de donos o que legitimaria, por exemplos, decisões judiciais que autorizam as empresas que constroem esses sistemas a se apropriarem de dados pessoais, de outras empresas, além de material produzido por artistas e cientistas, e outrora sujeitos a reinvindicações de direitos autorais.

Penn propõe a tese da doutrina do “Animo Nullius” (“a mente sem dono”) como um neologismo inspirado na doutrina da “Terra Nullius” (terra de ninguém). Assim como a última teria legitimado o colonialismo histórico, a primeira legitimaria um “colonialismo de dados”. Enquanto aquela seria justificada por levar a civilização e seus benesses a selvagens, essa nos traria a cura de doenças até então incuráveis, a resolução de todos os conflitos, o fim da necessidade do trabalho e, no limite, até à vida eterna.

A vontade de falar de metáforas e mitos construídos com elas este mês me veio ao assistir a refilmagem de “Frankenstein”, dirigido por Guillermo del Toro. Como escrevi aqui, o livro “Dr. Frankenstein, ou o Prometeu Moderno” é dos primeiros livros de ficção sobre uma inteligência artificial. A refilmagem é belíssima e repleta de metáforas que remetem à IA também em sua modernidade.

No filme, a construção da criatura de Frankenstein é financiada pela guerra e através da coleta de partes dos seus mortos, ignorando completamente os aspectos éticos dessa operação (um tipo de “Corpus Nullios”). O resultado é um amontoado de partes de diversas origens.

O objetivo do cientista Victor Frankenstein, um mentiroso patológico, é o domínio da natureza a qualquer custo, mas acaba sendo também prolongar a vida, motivo esse também herdado do seu principal financiador, cujos desejos e métodos ele prefere tratar com vista grossa.

A analogia com os tempos atuais se faz óbvia ao apostarmos em sistemas criados a partir de dados representando pedaços de vida de toda humanidade, ignorando os aspectos éticos dessa apropriação (seguindo o “Animo Nullios”), e em um processo financiado por empresas com óbvias propensões colonialistas e, por vezes, conduzidos por pessoas que preferem ignorá-las em nome de potenciais benefícios que essas novas criações poderiam trazer. Uma vez trazida à vida, a criatura é tratada por Frankenstein como um “tábula rasa” que deve aprender ainda tudo e através de um processo pavloviano de recompensa e punição (um tipo de aprendizagem por reforço).

No entanto, em comparação com nossos sistemas atuais de IA, a criatura de Frankenstein é muito mais sofisticada. Ela possui um senso comum inato e, por isso, é capaz de realmente aprender e a partir de um único exemplo (como uma criança que aprende o conceito de “Girafa” com um único exemplar ao invés de milhões de fotos).

É capaz de se adaptar a situações completamente novas, raciocinar metaforicamente e com isso abstrair e descobrir novas associações. Por exemplo, em um insight a criatura conclui que o caçador não odeia o lobo, assim como o lobo não odeia a ovelha mesmo quando agem com violência contra suas vítimas.

A criatura possui também uma teoria sobre a mente de outros seres (seus desejos, crenças, intenções) e é capaz de raciocinar contra factualmente, ou seja, sobre situações hipotéticas. Faz isso quando delibera sobre as possíveis consequências de revelar a sua existência a uma família humana e decide quando fazê-lo somente a um membro cego dessa família. Esse, um ancião, que lhe serve como uma base de conhecimento curado sobre o mundo e a humanidade – ao invés de uma fonte de dados esparsos.

A criatura entende também a realidade social como algo distinto do mundo físico (“com um único passo, entro em um novo mundo”, diz ao decidir revelar sua existência ao ancião) e apreende conceitos sociais como família, reciprocidade, e papéis sociais (por exemplo, ele entende que atua no papel de benfeitor da família).

Ela aprende sozinha o conceito de semântica de uma linguagem e sua função mágica de externalizar o conteúdo da mente (“essas pessoas possuem sons que usam para comunicar uns aos outros seus sentimentos e ideias. Elas chamam isso de palavras”), e demonstra que o aprendizado da linguagem não se dá de forma abstrata somente através de reforço, mas acontece no mundo, com corpos que existem e interagem fisicamente no mundo, que sentem, e em contextos de relações sociais.

Por fim, a criatura aprende também que, apesar de ser necessariamente de outra espécie diferente dos humanos, ser uma “pessoa” é também um papel que se exerce quando se é capaz de exibir humanidade – um raciocínio ontológico não trivial. Com isso, ela perdoa o seu criador e sente “alguém” e não “alguma coisa”, e também ensina uma lição ao capitão do navio encalhado no gelo que tem seu próprio insight metafórico extraído como lição da vida trágica de Frankenstein: também em sua vida e de seus marinheiros existem outros valores além da busca cega pela conquista e que, portanto, seria hora de voltar para casa.

A principal lição do filme (e do livro), no entanto, é que não se pode ao mesmo tempo produzir artefatos realmente inteligentes e ter controle absoluto sobre eles. Inteligência real ou controle, teremos que escolher um dos dois. Um ser verdadeiramente inteligente terá que ser necessariamente um ser autônomo.

Uma vez criado, podemos nunca mais conseguir extingui-lo. A criatura não pode ser morta, seja individualmente, seja pelas suas cópias. Na sua busca eticamente cega, Frankenstein não cria somente a vida, mas cria uma criatura capaz de sofrer e que, como deixa claro mais o livro que o filme, é incapaz de não seguir gerando sofrimento. Como diz a personagem Elizabeth (ela também uma metáfora de Mary Shelley) para o Dr. Frankenstein no filme: “Somente monstros brincam de Deuses, Barão”.

Notou alguma informação incorreta no conteúdo de A Gazeta? Nos ajude a corrigir o mais rápido possível! Clique no botão ao lado e envie sua mensagem.

Envie sua sugestão, comentário ou crítica diretamente aos editores de A Gazeta.