Parecia um dia normal de trabalho em 1966, até que Joseph Weizenbaum chegou ao seu escritório no Instituto de Tecnologia de Massachusetts (MIT) e encontrou uma cena que o deixaria perplexo e intrigado por muitos anos. Sua secretária estava chorando compulsivamente e, ao vê-lo, pediu-lhe privacidade para conversar a sós com seu terapeuta. A perplexidade de Weizenbaum vinha do fato do dito “terapeuta” ser um sistema de Inteligência Artificial.

Eu dramatizo um pouco a história, mas é verdade que a secretaria realmente pediu a Weizenbaum que a deixasse só para que se confidenciasse com o sistema. O sistema em questão havia sido projetado por Weizenbaum e, construído com a tecnologia da época, cabia em um daqueles antigos disquetes de memória. O sistema, que ele batizara com o nome de ELIZA, imitava um psicólogo Rogeriano, ou seja, seguia a linha proposta pelo psicoterapeuta americano Carl Rogers em que o terapeuta por vezes retorna ao seu paciente suas próprias perguntas.

Do ponto de vista computacional, ELIZA era bastante simples: identificava as palavras-chaves de uma frase, seguia padrões linguísticos pré-determinados em torno daquelas palavras-chave e, quando se perdia no diálogo, ou seja, quando uma frase do seu interlocutor fugisse aos seus padrões, ele propunha uma frase genérica, mas que, naquele contexto “terapêutico”, poderia ser interpretada como tendo sentido. O seguinte poderia ser um exemplo de um de seus diálogos (com as palavras-chave sublinhadas):

ELIZA: Como você está se sentindo hoje?

Humano: Estou me sentindo um pouco cansado.

ELIZA: Por que você está se sentindo cansado?

Humano: Acho que é devido ao meu trabalho.

ELIZA: Me fale sobre o seu trabalho.

E por aí seguiria o diálogo. Quando ELIZA se perdia, poderia então escrever: “Isso é interessante!” ou “Você não acha que está sendo muito negativo?”, ou ainda, “Como você acha que isso se relaciona com sua infância?”.

Simples, não? Poderíamos pensar: quem iria cair em um truque desses? Não só a secretaria de Weizenbaum mas uma enormidade de pessoas. Conta-se que, à época, até uma associação americana de psicólogos teria promovido um encontro para discutir o futuro da profissão agora que terapeutas artificiais supostamente existiam.

Vale lembrar que ELIZA fora construído como um sistema de regras que, como discutimos neste artigo, possuem uma grande transparência do seu processo de tomada de decisão. Nesse caso, por suas regras serem descritas explicitamente, podia-se ver exatamente como o “truque” funcionava. Ainda assim, as pessoas estavam convencidas que ELIZA possuía inteligência, empatia, intencionalidade, enfim, agência.

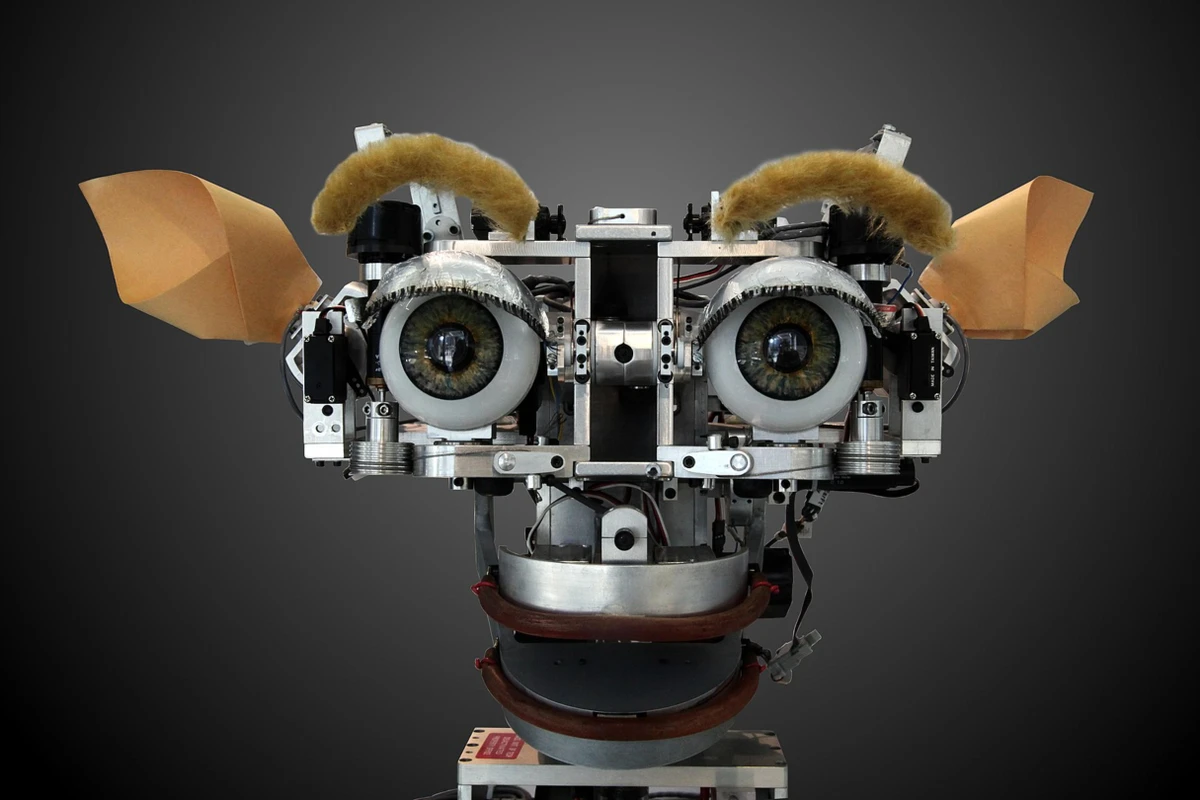

Cerca de 30 anos depois, no mesmo MIT, a cientista Cynthia Breazeal realizariam uma versão desse experimento utilizando um robô humanoide chamado Kismet (figura abaixo). Kismet emulava emoções e empatia com expressões em sua face artificial, respondendo de forma coerente às emoções expressas por seus interlocutores. O resultado foi que os participantes do experimento passavam um bocado de tempo “conversando” com esses robôs. Um deles inclusive relataria que nunca alguém o havia compreendido tanto quanto Kismet!

Esses experimentos nos mostraram quão inadequado poderia ser o chamado “Teste de Turing” como um teste de inteligência. O “teste” nunca tinha sido concebido como tal, mas como um experimento mental proposto pelo pioneiro da computação Alan Turing e que ele havia chamado originalmente de “O Jogo da Imitação” (título do filme homônimo sobre alguns aspectos da vida de Turing lançado em 2014).

De todo modo, o “teste” veio a ser interpretado essencialmente assim: um interrogador humano conversaria com dois interlocutores sem que pudesse vê-los (por exemplo, através de um diálogo textual por computador). Se um sistema artificial pudesse se passar por um dos interlocutores sem o que interrogador o identificasse, aquele sistema teria passado no “Teste de Turing” e poderia portanto ser considerado um sistema inteligente.

O “Teste de Turing” é completamente focalizado em uma única competência humana, a linguística, cuja escolha como indicador de inteligência não é por acaso, afinal, em humanos, ela requer capacidades que incluem planejamento (ou seja, a capacidade de imaginar futuros possíveis conectados por relações causais), memória (sobre acontecimentos, significados de palavras, fatos no mundo), capacidade de pensar sobre o estado mental de seus interlocutores (seus desejo, intenções, crenças), além da capacidade de responder a estímulos (nesse caso, frases) completamente novos: por exemplo, ao ouvir a frase “Alan Turing foi o Pelé da computação”, você sabe exatamente o que eu quero dizer, mesmo que nunca a tenha ouvido.

No entanto, como teste, ele tem uma importante limitação: quem julga o sucesso de um sistema artificial no “teste” é um interrogador humano e, portanto, sujeito a uma importante vulnerabilidade humana ligada a um fenômeno chamado apofenia. Apofenia é a tendência a enxergarmos significado na ausência dele.

Um fenômeno relacionado é o que chamamos de pareidolia, que é a tendencia a enxergarmos imagens em algumas formações geradas pelo acaso. Sabem quando vemos animais em nuvens e figuras religiosas em torradas e manchas de prédios, ou quando detectamos um rosto na superfície de Marte na foto abaixo? Pois é, pareidolia.

Para a nossa discussão, é relevante um outro fenômeno relacionado que, as vezes é chamado de agenticidade, mas que eu gosto de chamar de “Efeito Wilson”, em homenagem ao personagem de Tom Hanks no filme “Náufrago” (2000). No filme, o personagem de Hanks desenvolve uma complexa relação com uma bola de vôlei manchada de sangue que ele apelidara “Wilson”.

O Efeito Wilson é a nossa propensão de atribuir sentido, racionalidade e até agência na ausência delas e, por causa dele, o “Teste de Turing” corre o risco de funcionar melhor como um teste da nossa capacidade de autoengano, do que um teste de inteligência para máquinas.

Esse efeito deriva de uma capacidade extremamente útil selecionada pela evolução: a capacidade de explicar o ambiente no qual estamos inseridos. Nossos ancestrais foram bem-sucedidos na sua adaptação ao ambiente em que viveram porque foram capazes de enxergar além das aparentes características de objetos e aleatoriedade dos eventos, formulando teorias e detectando padrões que explicassem de forma correta as propriedades e relações envolvendo esses fenômenos.

O lado negativo é que essa capacidade por vezes nos faz ver coisas que não estão lá: partes que se movem juntas são vistas como compondo uma mesma entidade; uma coisa que se move de forma autônoma é vista como viva; uma coisa que imita um diálogo humano aparentemente coerente é vista como tendo humanidade, ou seja, sentimentos, inteligência e agência.

SISTEMAS SOFISTICADOS

Com a evolução tecnológica desde os tempos de Weizenbaum, fomos capazes de criar sistemas que emulam de forma bem mais sofisticada a linguagem e as emoções humanas. Por exemplo, os sistemas baseados em LLMs (grandes modelos de linguagem) são capazes de imitar diálogos humanos com grande precisão. Se eles nem sempre exibem essa precisão no conteúdo que geram — uma vez que lhes falta uma noção de verdade e lhes sobra uma propensão a confabular (ou “alucinar”) —, o fazem na forma, ao produzirem textos coerentes, verossímeis e sintaticamente sem falhas.

Essa precisão de forma nos faz acreditar nessas “alucinações”. Isso porque precisaríamos conhecer os fatos em questão para saber que elas são “alucinações” — o que nem sempre conhecemos —, mas, mais importante, porque ao nos depararmos com uma entidade aparentemente capaz de versar sobre qualquer assunto com fluência e eloquência, capaz de escrever poesia e tratados em segundos, somos imediatamente convencidos de se tratar de uma forma superior de inteligência e que, portanto, deve ter razão sobre tudo que está nos dizendo, inclusive quando o assunto em questão somos nós mesmos.

Temos aqui um exemplo de uma falácia que nos acomete com frequência: se uma entidade demonstra um comportamento que, se exibido por um humano, exigiria uma propriedade X (por exemplo, inteligência ou empatia), então essa entidade possui essa propriedade X.

Para perceber a falha no raciocínio só precisamos pensar em uma calculadora. Se para um humano, realizar cálculos complexos requer uma capacidade intelectual notável, isso não nos faria concluir que a nossa calculadora possui uma capacidade intelectual superior à nossa. Parece elementar, mas essa falácia nos fez atribuir inteligência no passado ao Deep Blue (pela sua capacidade sobre-humana de jogar xadrez), ao Watson (pelo seu conhecimento enciclopédico), à ELIZA e, agora mais do que nunca, aos Perplexity, Manus e ChatGPT.

Nossa propensão a essa falácia, combinada com a poderosa ilusão criada por esses sistemas modernos, cria um Efeito Wilson hiperanabolizado que, novamente, se aproveita continuamente dessa nossa vulnerabilidade e, recentemente, nos tem colocado sob riscos importantes: por exemplo, as pessoas têm delegado a esses sistemas o diagnóstico de suas doenças, a recomendação dos seus tratamentos e, remontando à ELIZA e à secretária de Weizenbaum, a elaboração dos seus transtornos mentais.

Weizenbaum teria batizado seu sistema em referência à personagem Eliza Doolitle (da peça “Pigmalião” de George Bernard Shaw), cuja capacidade notável seria gerar uma ilusão (de que seria uma Duquesa) através de seu uso elaborado da linguagem. Ao construir esses sistemas, descobrimos de forma análoga que: para reconhecer emoções, precisamos apenas aprender como elas correlacionam com certos dados biométricos (por exemplo, tom de voz, movimento dos olhos e dos músculos da face, condutividade elétrica na pele); para emulá-las, só precisaríamos refletir alguns desses sinais em uma face artificial e alguns desses tons em uma voz sintetizada; para criar diálogos sintaticamente corretos e coerentes, precisaríamos “apenas” ingerir praticamente todos os textos produzidos e digitalizados pela humanidade e, a partir deles, gerar uma colcha de retalhos cerzida com um “fio probabilístico capaz de regurgitar, não só esses textos, mas todos aqueles que poderíamos ter escrito a partir da combinação de seus fragmentos".

Se esses sistemas baseados em IA generativa nos respondem “com emoção” é porque foram alimentados com uma enormidade de textos produzidos por humanos exibindo emoções; se parecem se comportar melhor quando os tratamos com cortesia é porque, em textos produzidos por humanos, cortesia é correlacionada com educação, conhecimento, letramento; se parecem capazes de dar conselhos é porque ingeriram textos com centenas de relatos e casos clínicos.

Em combinação com a capacidade artificial quase inimaginável de processar todos os nossos dados e identificar esses padrões estatísticos, a ilusão é potencializada pelo Efeito Wilson. Ou seja, nós somos participantes ativos na construção dessa ilusão e do nosso autoengano.

Esses sistemas não podem ser nossos parceiros sentimentais, nossos amigos e, muito menos, nossos terapeutas. Nenhum sistema artificial atual possui emoções ou intencionalidade. Eles não são capazes de raciocinar sobre nada que desvie substancialmente dos dados em que foram treinados, e não têm como empatizar com a experiência humana e entender as enormes sutilezas que conectam as nossas emoções, a nossa história individual e coletiva, e a nossa cognição.

Além disso, como não têm como entender os efeitos de suas ações, esses sistemas não têm como se alinhar aos interesses e valores humanos e como oferecer segurança nas suas ações, ou seja, não têm como garantir que sempre se comportarão eticamente.

No melhor dos casos, o diálogo com essas máquinas é uma caixa de ressonância em que conversamos com nós mesmos e, em um sentido muito liberal e quase poético, com toda a humanidade e com o que ela foi capaz de produzir; no pior dos casos, esses sistemas poderiam nos desestabilizar mentalmente, e, no limite, nos induzir a crimes e até ao suicídio.

Assim como no caso do personagem de Tom Hanks, o nosso Wilson pode até nos ter serventia como interlocutor. A nós, adultos, responsáveis e com razoável discernimento e controle psíquico e emocional. No entanto, o risco pode ser grande demais para pessoas mais vulneráveis e, ao que tudo indica, mais propensas à falsa atribuição de inteligência, agência e empatia a esses sistemas. Em outras palavras, a condição de segurança aqui é nunca esquecermos que, por trás de toda sofisticação tecnológica, não existe agência, senciência, real inteligência, ou empatia, mas somente uma “bola de vôlei manchada de sangue”.

Notou alguma informação incorreta no conteúdo de A Gazeta? Nos ajude a corrigir o mais rápido possível! Clique no botão ao lado e envie sua mensagem.

Envie sua sugestão, comentário ou crítica diretamente aos editores de A Gazeta.